Когда дело доходит до игр, ничто не сравнится с PC Master Race. Позвольте мне объяснить. Уровень настраиваемости, а также грубая мощь, которой может достичь идеально спроектированная игровая установка, - это то, о чем можно только мечтать. При этом даже игры на ПК подвержены определенным лазейкам, и эти лазейки могут испортить игровой процесс. Если вы страстный геймер или кто-то, кто пристально следит за игровыми форумами, вы наверняка слышали об одной из главных проблем для любого геймера - разрыве экрана. В то время как существует традиционное решение в виде V-Sync, более новые технологии привели к появлению других решений в виде NVIDIA G-Sync и AMD FreeSync. Сегодня мы рассмотрим эти два G-Sync против FreeSync, чтобы увидеть, какой из них выйдет на первое место. Но сначала позвольте нам пролить свет на то, в чем именно заключается проблема.

Что такое разрыв экрана?

Если вы играли на установке, у которой нет очень мощного монитора, вы наверняка сталкивались с этим раздражающим явлением, которое разрывает экран. Разрыв экрана - это эффект, который возникает на видеоисточнике, когда 2 или более кадра видео отображаются вместе в одном кадре, вызывая эффект разрыва. Видите ли, поскольку графические процессоры становятся все более и более мощными, они захотят выдвинуть как можно больше кадров в кратчайший промежуток времени. Хотя это звучит замечательно, если частота обновления вашего монитора фиксирована, скажем, 75 Гц, даже если несколько кадров для анимации выдвигаются, ваш монитор не будет готов к этому.

Например, представьте, что вы играете в игру на графическом процессоре, который способен выдавать 100 кадров в секунду. Это означает, что монитор обновляется 75 раз в секунду, но видеокарта обновляет дисплей 100 раз в секунду, что на 33% быстрее, чем монитор. В результате между обновлениями экрана видеокарта отрисовывает один кадр, а третий - другой. Эта треть следующего кадра перезапишет верхнюю треть предыдущего кадра, а затем отобразится на экране. Затем видеокарта завершает последние две трети этого кадра и отображает следующие две трети следующего кадра, а затем экран снова обновляется.

Вы увидите только часть происходящего: часть текущего кадра и часть следующего кадра (ов). В результате создается впечатление, что изображение на экране разделено на несколько частей, что нарушает внешний вид игры. Другая причина, по которой это может иметь место, - это когда графический процессор системы испытывает давление из-за большого объема графической обработки или плохого программирования. Когда графический процессор находится под большим давлением, он не сможет синхронизировать выходное видео, что приведет к разрыву экрана.

V-Sync и необходимость в альтернативе

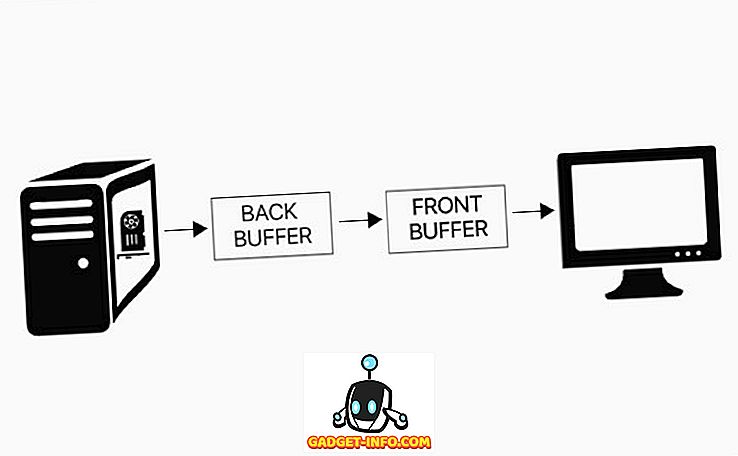

Для любого игрока разрыв экрана - досадный случай. Идеально отрисованный заголовок может быть полностью разрушен грубыми горизонтальными линиями и заиканием кадра. Разработчики вскоре осознали эту проблему и выпустили V-Sync. Вертикальная синхронизация или V-Sync призвана решить проблему разрыва экрана с помощью двойной буферизации.

Двойная буферизация - это метод, который смягчает проблему разрыва, предоставляя системе буфер кадров и резервный буфер . Всякий раз, когда монитор захватывает кадр для обновления, он извлекает его из буфера кадров. Видеокарта рисует новые кадры в заднем буфере, а затем копирует их в буфер кадров, когда это будет сделано. Согласно предопределенным правилам V-Sync, задний буфер не может копироваться в буфер кадров до тех пор, пока монитор не обновится . Задний буфер заполняется кадром, система ждет, и после обновления задний буфер копируется в буфер кадров, и в задний буфер выводится новый кадр, эффективно ограничивая частоту кадров при частоте обновления.

Хотя все это хорошо звучит и помогает устранить разрывы экрана, V-Sync имеет свои недостатки . В V-Sync частота кадров может быть равна только дискретному набору значений, равному (Refresh / N), где N - некоторое положительное целое число. Например, если частота обновления вашего монитора составляет 60 Гц, частота кадров, с которой будет работать ваша система, будет 60, 30, 20, 15, 12 и т. Д. Как видите, падение с 60 кадров в секунду до 30 кадров в секунду является большим. Кроме того, при использовании V-Sync любая частота кадров в диапазоне от 60 до 30, которую может выдвинуть ваша система, будет снижена только до 30.

Кроме того, самая большая проблема с V-Sync - задержка ввода. Как упомянуто выше, в случае V-Sync кадры, которые GPU хочет выдвинуть, сначала будут удерживаться в заднем буфере и будут отправляться в буфер кадров только тогда, когда монитор дает к нему доступ. Это означает, что любой ввод, который вы дадите системе, также будет сохранен в этом заднем буфере вместе с другими кадрами. Только когда эти кадры будут записаны в основной кадр, будет показан ваш ввод. Таким образом, системы могут испытывать задержки ввода до 30 мс, что может реально помешать вашему игровому опыту.

Альтернативы: G-Sync и FreeSync

Видите ли, будь то традиционно или с помощью V-Sync, именно монитор всегда вызывал проблемы. Основное питание всегда отдавалось мониторам, и они использовали его не по назначению, чтобы ограничить количество кадров, передаваемых им. Независимо от того, сколько изменений уровня программного обеспечения вы делаете, аппаратное обеспечение всегда будет иметь свои пределы. Но что, если бы было другое решение, которое позволило бы графическим процессорам получить высшую власть? Cue - мониторы с переменной частотой обновления .

Как следует из названия, мониторы с переменной частотой обновления являются мониторами с ограничением частоты обновления, но без фиксированной частоты обновления. Вместо этого они полагаются на графический процессор, чтобы изменить частоту обновления . Теперь этот подвиг достигается с помощью одной из двух технологий - NVIDIA G-Sync или AMD FreeSync.

G-Sync от NVIDIA, запущенный еще в 2013 году, нацелен на решение этой проблемы, предоставляя графическому процессору полное право решать, сколько кадров будет отображаться на экране. Монитор вместо фиксированной частоты обновления адаптируется к скорости обработки графического процессора и соответствует выходной частоте кадров в секунду . Так, например, вы играете в игру со скоростью 120 кадров в секунду, тогда ваш монитор также будет обновляться со скоростью 120 Гц (120 раз в секунду). А в случае высоких требований к графической обработке, когда ваш графический процессор сбрасывает кадры до 30 кадров в секунду, монитор соответственно изменит свою частоту обновления до 30 Гц. Таким образом, нет потерь в кадрах, и данные непосредственно передаются на дисплей, таким образом устраняя любую область для разрыва или задержки ввода.

Теперь, когда NVIDIA является королем в области игр, ее крупнейший конкурент AMD не отстает. Итак, когда NVIDIA выпустила G-Sync, как AMD могла остаться? Чтобы остаться в конкурентной борьбе, AMD представила свое решение для технологии V-Sync - FreeSync. Созданный в 2015 году, AMD FreeSync работает по тому же принципу, что и NVIDIA G-Sync, позволяя графическому процессору быть главным и контролировать частоту обновления монитора. Хотя цель G-Sync и FreeSync одинакова, разница между ними заключается в том, как они добиваются ее.

G-Sync против FreeSync: как они работают?

NVIDIA разработала G-Sync для устранения проблем на обоих концах. G-Sync - это запатентованная технология адаптивной синхронизации, что означает использование дополнительного аппаратного модуля . Эта дополнительная микросхема встроена в каждый поддерживаемый монитор и позволяет NVIDIA точно настраивать параметры, исходя из таких характеристик, как максимальная частота обновления, экраны IPS или TN и напряжение. Даже когда ваша частота кадров становится очень низкой или очень высокой, G-Sync может сохранять вашу игру гладкой.

Что касается FreeSync от AMD, такой модуль не требуется . В 2015 году VESA анонсировала Adaptive-Sync как компонент компонента спецификации DisplayPort 1.2a. FreeSync использует протоколы DisplayPort Adaptive-Sync, чтобы позволить GPU контролировать частоту обновления. Кроме того, позднее он расширил свою поддержку и для портов HDMI, что делает его привлекательным для большего числа потребителей.

Ghosting

В аспекте дисплеев ореолы используются для описания артефакта, вызванного медленным временем отклика . Когда экран обновляется, человеческий глаз все еще воспринимает ранее отображенное изображение; вызывая размытие или размытие визуального эффекта. Время отклика является мерой того, насколько быстро данный пиксель может изменить состояние с одного цвета на другой. Если время отклика вашего дисплея не синхронизировано с кадрами, которые выдвигает графический процессор, вы, скорее всего, столкнетесь с ореолом. Этот эффект характерен для большинства ЖК-панелей или панелей с плоским экраном. Хотя по сути это не разрывание экрана, ореолы не слишком далеки от концепции, учитывая тот факт, что новые кадры накладываются на предыдущие кадры без их полного исчезновения с экрана.

Поскольку модуль NVIDIA G-Sync работает с помощью дополнительного аппаратного модуля, он позволяет G-Sync предотвращать двоение, настраивая способ работы модуля на каждом мониторе. С помощью AMD FreeSync эти настройки выполняются в самом драйвере Radeon, отводя задачу от монитора. Как вы можете видеть, это аппаратный и программный модуль управления, и NVIDIA здесь легко побеждает. Хотя ореолы не распространены на мониторах FreeSync, они все еще присутствуют . С другой стороны, так как каждый монитор физически настроен и настроен, G-Sync не испытывает никаких побочных эффектов на своих панелях.

гибкость

В погоне за разрывом экрана было решено обеспечить максимальный контроль над графическим процессором. Но, как однажды сказал дядя Бен, «с большой силой приходит большая ответственность». В этом случае графический процессор отнимает все мощности у монитора, более или менее. Например, вы должны учитывать тот факт, что большинство мониторов, помимо обычной регулировки яркости и контрастности, также имеют свои собственные функции, которые позволяют дисплею динамически регулировать настройки на основе входного сигнала, который им подается.

Поскольку NVIDIA G-Sync использует дополнительный запатентованный модуль, она убирает эту функцию с экрана дисплея, предоставляя возможность динамической настройки графического процессора. С другой стороны, AMD FreeSync не вносит таких изменений и позволяет экрану иметь собственную функцию динамической регулировки цвета. Наличие ваших личных изменений в качестве опции важно для любого производителя, поскольку это помогает им получить преимущество над другими производителями. Именно поэтому многие производители предпочитают выбирать FreeSync вместо G-Sync.

G-Sync против FreeSync: совместимые устройства

Для того, чтобы любое устройство было совместимо с модулем G-Sync от NVIDIA, оно должно встраивать собственный чип модуля NVIDIA в свои дисплеи. С другой стороны, AMD FreeSync может использоваться любым монитором с переменной частотой обновления и портом DisplayPort или HDMI.

При этом ваш графический процессор также должен быть совместим с соответствующими технологиями (да, вы не можете смешивать и сопоставлять графический процессор одного производителя с технологией синхронизации другого). Будучи представленным почти на 2 года раньше своего конкурента, NVIDIA G-Sync имеет довольно много графических процессоров под поддерживаемым тегом G-Sync. Все графические процессоры среднего и высшего класса от 600 до 1000 серий отмечены знаком G-Sync.

Для сравнения, на момент написания этой статьи AMD поддерживает только 9 графических процессоров, использующих технологию FreeSync, по сравнению с NVIDIA 33. Кроме того, NVIDIA также расширила поддержку G-Sync для ноутбуков и ноутбуков, в настоящее время эта функция отсутствует. от AMD FreeSync.

Устройства, совместимые с NVIDIA G-Sync

| GTX 600 Series | GTX 700 Series | GTX 900 Series | GTX 1000 Series | Серия Титан |

|---|---|---|---|---|

| GeForce GTX 650 Ti Boost | GeForce GTX 745 | GeForce GTX 950 | GeForce GTX 1050 | GeForce GTX Titan |

| GeForce GTX 660 | GeForce GTX 750 | GeForce GTX 960 | GeForce GTX 1050 Ti | GeForce GTX Titan Black |

| GeForce GTX 660 Ti | GeForce GTX 750 Ti | GeForce GTX 965M | GeForce GTX 1060 | GeForce GTX Titan X |

| GeForce GTX 670 | GeForce GTX 760 | GeForce GTX 970 | GeForce GTX 1070 | GeForce GTX Titan Xp |

| GeForce GTX 680 | GeForce GTX 770 | GeForce GTX 970M | GeForce GTX 1080 | GeForce GTX Titan Z |

| GeForce GTX 690 | GeForce GTX 780 | GeForce GTX 980 | GeForce GTX 1080 Ti | |

| GeForce GTX 780 Ti | GeForce GTX 980M | |||

| GeForce GTX 980 Ti |

AMD FreeSync совместимые устройства

| Графические процессоры | APUs |

|---|---|

| Radeon R7 260X | Kaveri |

| Radeon R7 360 | Kabini |

| Radeon R9 285 | Temash |

| Radeon R9 290 | Beema |

| Radeon R9 290X | Mullins |

| Radeon R9 380 | Carrizo |

| Radeon R9 390 | Бристоль Ридж |

| Radeon R9 390X | Вороний хребет |

| Radeon R9 Fury X |

Стоимость проектирования и доступность

G-Sync от NVIDIA использует дополнительное аппаратное обеспечение, что в основном означает, что производители дисплеев должны освободить больше места внутри корпуса монитора . Хотя это может показаться незначительным, создание индивидуального дизайна продукта для одного типа монитора значительно увеличивает затраты на разработку. С другой стороны, подход AMD является гораздо более открытым, в котором производители дисплеев могут включить эту технологию в свои существующие проекты.

Чтобы показать вам более широкую картину (без каламбура), 34-дюймовый ультраширокий монитор LG с поддержкой FreeSync обойдется вам всего в 397 долларов. В то время как один из самых дешевых сверхшироких мониторов в настоящее время доступен, 34-дюймовый вариант LG с поддержкой G-Sync обойдется вам в $ 997. Это почти разница в 600 долларов, которая может легко стать решающим фактором при совершении следующей покупки.

G-Sync против FreeSync: лучшее решение с переменной частотой обновления?

И NVIDIA G-Sync, и AMD FreeSync успешно устраняют проблему разрыва экрана. Хотя технология G-Sync определенно дороже, она поддерживается в более широком диапазоне графических процессоров, а также обеспечивает нулевое двоение изображения. AMD FreeSync на другом конце направлена на предоставление более дешевой альтернативы, и, хотя количество мониторов, поддерживающих ее, довольно велико, на данный момент поддерживается не так много основных графических процессоров. В конечном счете, выбор за вами, хотя вы не ошибетесь ни с одним из них. Расскажите нам о любых других вопросах, которые могут у вас возникнуть в разделе комментариев ниже, и мы постараемся помочь вам.